Chi controlla che i contenuti pubblicati sui social siano appropriati e non violino regole etiche o sociali?

Per ora non ci sono agenti dedicati, ma le piattaforme dispongono di specifici software e di comitati di persone in carne e ossa.

Tuttavia, per disciplinare l’enorme massa di post che appare quotidianamente occorre ancora molto lavoro e una normativa internazionale.

1. “Liste nere”

Dalla repressione di Hong Kong ai deliri complottisti di QAnon, sui social sembra che chiunque possa dire qualsiasi cosa gli passi per la mente. In realtà non è proprio così, come abbiamo scoperto all’inizio di quest’anno con l’eliminazione del profilo Twitter dell’ex presidente USA Donald Trump.

Ci sono regole di conversazione, che ogni piattaforma indica come policy, che proibiscono espressioni o riferimenti che offendono o discriminano.

Ma chi è che controlla? Su Facebook, per esempio, ci sono oltre 350 milioni di post al giorno: come è possibile tenerli tutti sotto osservazione?

Il corpo di polizia dei social media, se così possiamo dire, è composto da software che ogni giorno passano in rassegna i contenuti pubblicati.

A monte, però, ci sono le cosiddette black list, cioè liste di espressioni e termini che fanno scattare l’allarme: esse sono compilate da esseri umani così come le segnalazioni spontanee che provengono dagli utenti della rete.

Provate, anche solo per gioco, a pubblicare qualche video di piazza Tienanmen o della repressione a Hong Kong su TikTok, il social media più frequentato dagli adolescenti: è molto probabile che il video non sarà visibile dalla maggior parte degli iscritti, come se fosse oscurato. Perché?

Semplice: anche in assenza di conferme ufficiali, Bytedance, la società che ha sviluppato TikTok, è basata in Cina ed è sottoposta alla censura dello Stato, ragione per cui non tutto si può dire su questa app.

Lo stesso discorso vale per Facebook: provate a iscrivervi indicando come luogo di lavoro Cambridge Analytica, la società all’origine dello scandalo sulla raccolta impropria dei dati degli utenti. Anche se l’azienda non esiste più, è probabile che il vostro profilo sia messo in pausa, in attesa di accertamenti.

Con questi due semplici esempi, ben lontani dalle narrazioni tossiche di complottisti o terroristi dell’ISIS, viene naturale chiedersi: ma è possibile che sia un privato – il signor Zuckerberg o il Mr Twitter – a stabilire cosa e come si possono dire le cose?

2. Termini sessuali. No a odio e discriminazione

Qualche tempo fa Facebook ha rivelato che, in circa quattro mesi di tempo, elimina in media 865 milioni di post, che non rispettano le regole della community.

Le operazioni di controllo sui contenuti sono sia ingegneristiche, cioè eseguite da software informatici, sia umane, cioè eseguite da persone.

La parte elettronica è una sorta di allarme perimetrale che si attiva quando, per esempio, compaiono termini sessuali.

È difficile generalizzare perché ogni social media ha le sue regole, ma in alcune piattaforme è sufficiente l’allerta alzata dall’algoritmo a far scattare dei provvedimenti in automatico, mentre per altre esiste un comitato di persone che valuta i singoli casi.

Come per la polizia in carne e ossa, che non può controllare tutti, anche sui social media si fanno indagini a campione. Si può però dire che i social più diffusi sono anche quelli meno permissivi, mentre in quelli più piccoli, come il servizio di messaggistica di Telegram, le maglie sono più larghe.

Su Twitter si rischia il cartellino rosso quando si esprimono termini che incitano all’odio o alla discriminazione o immagini con nudi non consensuali ed esiste un pacchetto di linee guida anche per le Forze dell’ordine per individuare i responsabili di reti di diffamazione o altro.

Ma l’espulsione o l’oscuramento, come accade per tutti i social media, possono essere richiesti anche da un singolo utente, magari infastidito per un contenuto sgradevole. Quando arriva una richiesta del genere, prima di passare ai fatti, si viene avvertiti e si può replicare a propria difesa.

Ci sono pagine e pagine piene di regolamenti sul linguaggio e sui comportamenti da tenere su tutte le piattaforme social ma, come si dice, “fatta la legge, trovato l’inganno”.

Ormai si moltiplicano i modi per aggirare i divieti usando numeri al posto delle lettere, storpiando le parole o addirittura inserendo il testo in un’immagine che il sistema non è in grado di decifrare.

3. Errori in buona fede

Quando sono i software a fare i controlli non sempre tutto fila per il verso giusto.

Si tratta infatti di una forma di censura orizzontale, che spesso non distingue tra buona e cattiva fede: come è capitato un paio di anni fa a una concessionaria di Treviso che aveva deciso di investire in pubblicità su Facebook.

Peccato che il nome della società, richiamando il cognome del titolare, peraltro molto diffuso in Italia, fosse “Negro Automobili”. Il network ha bloccato la pubblicazione dei contenuti sponsorizzati dall’azienda perché, secondo l’algoritmo, conteneva volgarità e poteva offendere le persone.

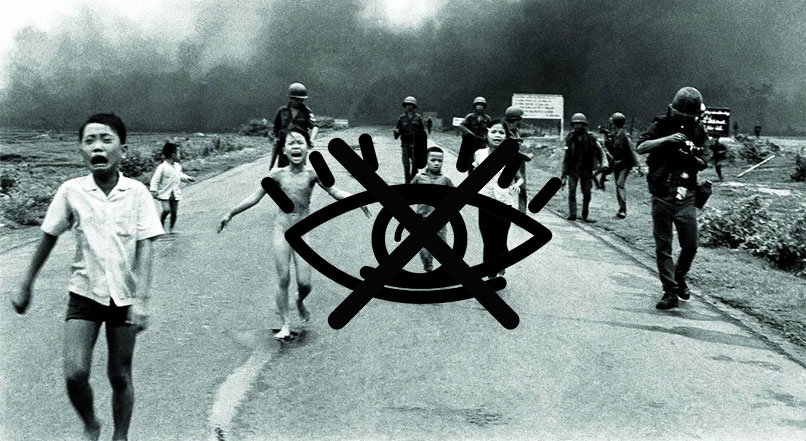

In questo caso non c’erano davvero le condizioni per fermare il post, ma è successo lo stesso. Così come non c’erano le condizioni quando nel 2016 è stata censurata, sempre su Facebook, l’immagine della “Napalm Girl”, la famosa foto che ritrae una bambina che corre nuda dopo essere stata colpita da un attacco al napalm durante la guerra del Vietnam.

Tecnicamente è stata definita “materiale pedopornografico” perché il soggetto è una minorenne nuda. In realtà quell’istantanea, scattata dal fotografo vietnamita Nick Út, è uno dei pezzi di giornalismo più significativi della storia perché racconta cosa stava accadendo nel Sudest asiatico.

Ha un valore di comunicazione pubblica che è stato completamente dimenticato. Nelle maglie della censura orizzontale, infine, spesso rischiano di finire anche quanti usano quelle parole per denunciare episodi di violenza o di razzismo.

4. Lingue diverse

Definire come funzioni la libertà di espressione in queste nuove piattaforme di interazione sociale interamente digitali non è semplice per il volume esorbitante di contenuti pubblicati ogni giorno in lingue diverse (61 su Twitter, 111 su Facebook).

Le conversazioni sui social non sono surrogati assimilabili a quello che avviene nel mondo reale anche perché spesso sono gli algoritmi a decidere quali contenuti rendere più visibili in base alle statistiche di engagement (coinvolgimento), che includono reazioni, commenti, like a un post.

Più che provare ad applicare le nostre leggi sulla libertà di espressione sui social media bisognerebbe tradurle in modo da renderle applicabili in questa dimensione relazionale, diversa da quella fisica.

È necessario, in altre parole, adattare le regole delle nostre società democratiche a questo nuovo mondo.

Per ora siamo ancora indietro. Per valutare se un contenuto vada eliminato sarebbe opportuno analizzare testo, contesto e interlocutori, fattori spesso tralasciati perché l’algoritmo non è così raffinato da interpretarli.

Twitter ha prima oscurato e poi eliminato l’account dell’ex presidente USA. Da una parte si può dire che ha agito contro i contenuti che istigano all’odio. In realtà, in democrazia, oltre al risultato conta anche il percorso, e nel caso di Trump la decisione di oscurarne il profilo non è stata condivisa o partecipata, creando un precedente pericoloso.

È quindi necessario che ci sia la possibilità di partecipare alla scrittura delle regole sui social media e che quando si decide di sospendere una figura così rilevante, ciò debba essere risultato di un processo istituzionale, non la scelta di una società privata.

5. Facebook, TikTok e Instagram

- Cinque contenuti proibiti su Facebook

Meno di un anno fa Facebook ha pubblicato le linee guida sulla censura dei contenuti sulla piattaforma. In linea di massima si può dire che i post a rischio possano essere catalogati in 5 grandi tipologie correlate a:

- Violenza e comportamenti criminali

- Contenuti deplorevoli

- Sicurezza

- Integrità e autenticità

- Rispetto della proprietà intellettuale.

- Proibito “parlar male” della Cina su TikTok

Su TikTok non osare parlare di piazza Tienanmen o della repressione a Hong Kong, né dell’indipendenza del Tibet. Ignora anche il Falun Gong, non si sa mai, e magari non citare Gandhi e nemmeno Trump. Evita anche di dire qualcosa sulla Cambogia o su Taiwan.

Secondo un documento riservato, pubblicato di recente dal quotidiano inglese The Guardian, ci sono una nutrita serie di parole tabù su questa app, sviluppata dalla società cinese ByteDance, che da parte sua ha replicato di avere “politiche di moderazione” mirate a ridurre i conflitti tra le persone.

- A moderare i commenti su Instagram ci pensa l’intelligenza artificiale

Per moderare i contenuti pubblicati, Instagram ricorre a filtri specifici basati sull’intelligenza artificiale: uno dedicato ai commenti offensivi e un altro rivolto ai commenti spam.

Questi filtri “aiutano” il sistema a capire da solo quando è il momento di intervenire presso gli utenti e dovrebbero essere in grado di individuare quali sono i post offensivi.

In realtà, per sicurezza, a questi software è associato un team di moderatori in carne e ossa.